Bedingt durch den Wunsch, tiefere Einblicke in komplexe prüfungsrelevante Sachverhalte zu gewinnen, setzen Prüfer:innen zunehmend auch Modelle der Künstlichen Intelligenz (KI) ein. Diese Modelle speichern Wissen, welches aus den internen und externen Daten der geprüften Organisationen gewonnen wird. Einmal erlernt, unterstützen KI-Modelle in einer Vielzahl von Prüfungshandlungen. [1],[2] Bereits heute werden KI-Modelle in der Prüfung eingesetzt, wie beispielsweise für das Audit Sampling [3], das Journal Entry Testing [4] und die Prüfung von Anhangsangaben [5].

Anhand verschiedenster Prüfsituationen erwerben Prüfer:innen im Rahmen ihrer beruflichen Laufbahn umfangreiche Expertise. Die Vielfalt an Erfahrungen ermöglicht es Fähigkeiten zu vertiefen und zu spezialisieren. Ein solches Lernen wirft die Frage auf: Wie können kumulativen Lernerfahrungen durch KI-Modelle realisiert werden?

Zugleich analysieren Prüfgesellschaften oftmals vertrauliche und personenbezogene Informationen. Die Nutzung mandatsübergreifender KI-Modelle erfordert die Einhaltung von Datenschutz-, Datensicherheits- und Vertraulichkeitsbestimmungen. Im Zielbild steht ein Lernparadigma, das es ermöglicht Wissen zu akkumulieren ohne sensitive Daten zu teilen.

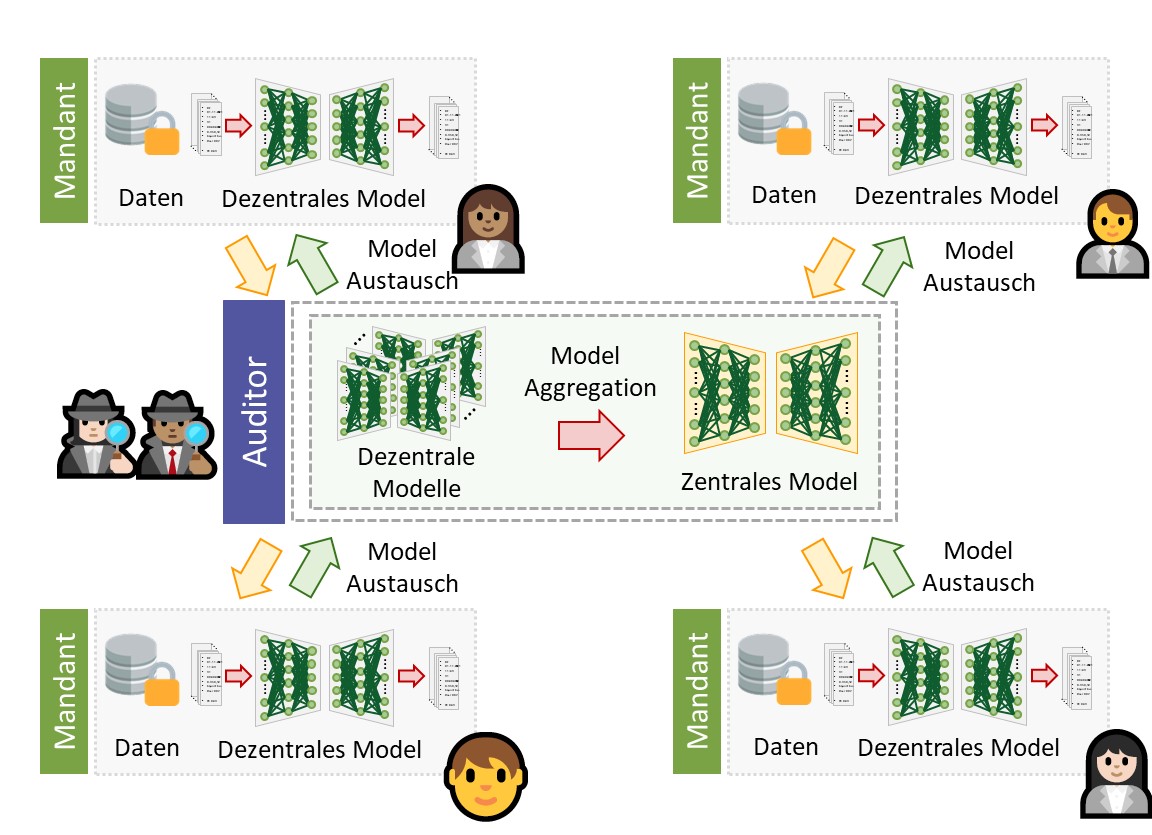

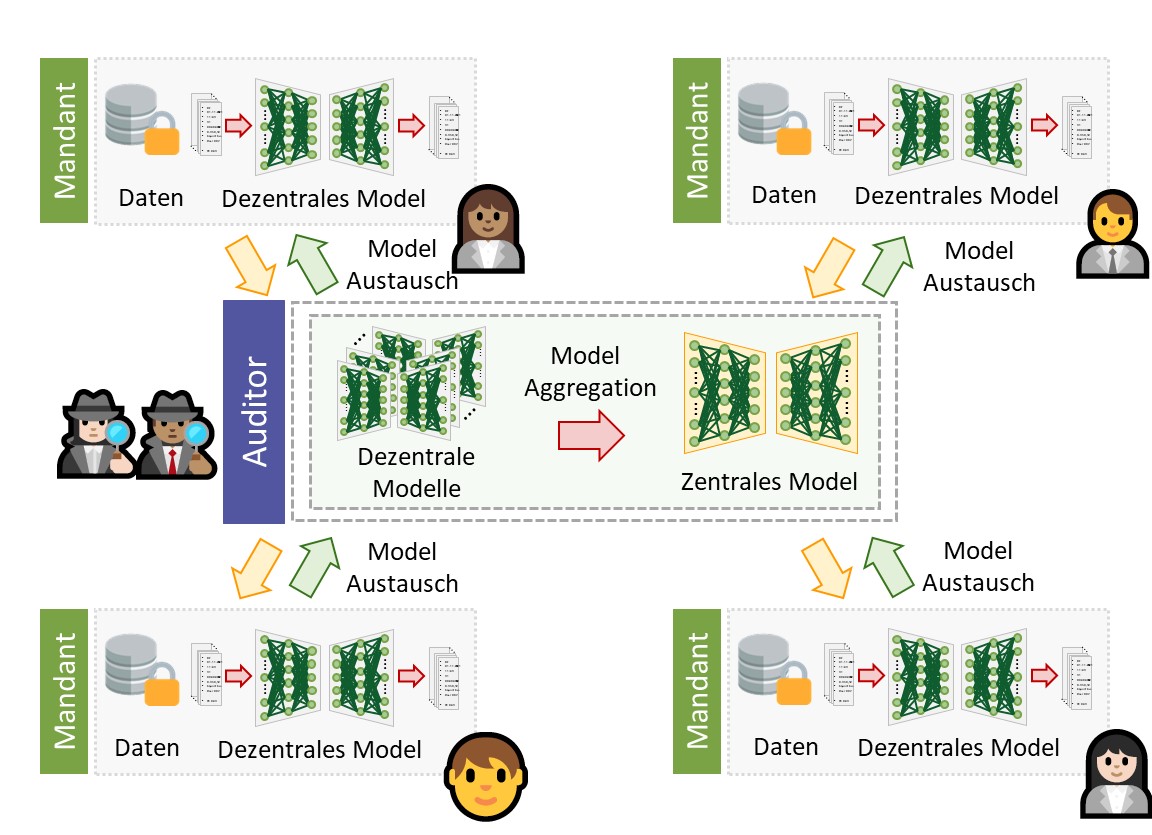

Das Federated-Learning [6] ermöglicht es mehreren Entitäten, wie Prüfmandanten oder Organisationseinheiten, ein gemeinsames KI-Modell zu erlernen. Die für das kollektive Modellernen erforderlichen Daten verbleiben bei den Entitäten und werden nicht geteilt.

Das Federated-Learning unterscheidet zwischen zentralen und dezentralen KI-Modellen. Ein zentrale KI-Modell entsteht hierbei durch die Kollaboration mehrerer dezentraler Entitäten. Jede Einheit erlernt zunächst ein lokales und zugleich dezentrales KI-Modell. Nach Abschluss der verschiedenen dezentralen Lernprozesse werden die einzelnen Modelle zu einem zentralen Modell zusammengeführt. Im prüferischen Kontext wird ein Federated-Learning-Prozess anhand der nachfolgenden sechs Schritte realisiert: [7]

Die Schritte 2-5 des Prozesses werden iterativ wiederholt, um das zentrale KI-Modell kontinuierlich zu verbessern. Mit fortschreitendem Lernen umfasst das zentrale KI-Modell zunehmend die kollektive Intelligenz der teilnehmenden Entitäten. Nach Abschluss des Lernvorgangs steht das zentrale KI-Modell allen Entitäten nutzenstiftend zur Verfügung.

Abbildung: Federated-Learning eines zentralen KI-Modells in der Prüfungspraxis aus proprietären Buchhaltungsdaten verschiedener Prüfungsmandaten. [8]

Federated-Learning unterstützt das zunehmende Bestreben, KI-Modelle datenschutzkonform anhand vielfältiger Wissensquellen für zunehmend komplexere Prüfungshandlungen zu optimieren [9]. Im Rahmen einer Studie bestätigten Hoitash et al. [10], dass Modelle, die sogenannte Peer-Klienten-Daten berücksichtigen, in verbesserte Prognosen resultieren.

Demzufolge können in der internen Prüfung Revisionen Federated-Learning nutzen, um ganzheitliche KI-Modelle auf Ebene der Organisation zu erlernen, beispielsweise um Risiken zu mindern und die Qualität der Prüfung zu verbessern. Weiterhin können in der externen Prüfung Prüfgesellschaften Federated-Learning nutzen, um KI-Modelle über mehrere Sektoren hinweg zu lernen, beispielsweise um kollektive Intelligenz zu nutzen und Effizienz der Prüfung zu steigern.

KI-Modelle, die kollektives Wissen nutzen, um ihre Fähigkeiten zu verbessern, haben das Potenzial, das nächste Kapitel von KI Co-Piloten in der Prüfung zu prägen. Der Zertifikatsstudiengang Certified Audit Data Scientist nimmt diese innovativen Lernparadigmen auf und vermittelt Kenntnisse fortschrittlicher Prüfverfahren.

———————————————————————————————————————————–

Dieser Blogbeitrag stellt einen Auszug des nachfolgenden, durch den Autor gemeinsam mit Co-Autoren veröffentlichten Beitrags dar: „A Sum Greater than its Parts: Collective Artificial Intelligence in Auditing – Advancing Audit Models through Federated Learning Without Sharing Proprietary Data“, Schreyer, M., Borth, D., Flemming, T. F., und Vasarhelyi, M. A. (EXPERTSuisse, Expert Focus, April 2024, S. 180-186).

———————————————————————————————————————————–

[1] Gu, H., Schreyer, M., Moffitt, K., & Vasarhelyi, M. A. (2023). Artificial Intelligence Co-Piloted Auditing. SSRN. https://doi.org/10.2139/ssrn.4444763

[2] Eulerich, M., & Wood, D. A. (2023). A Demonstration of How ChatGPT Can be Used in the Internal Auditing Process. SSRN. https://doi.org/10.2139/ssrn.4519583

[3] Schreyer, M., Gierbl, A. S., Ruud, F., & Borth, D. (2022). Stichprobenauswahl durch die Anwendung von Künstlicher Intelligenz-Lernen repräsentativer Stichproben aus Journalbuchungen in der Prüfungspraxis. Expert Focus, (02), 10-18.

[4] Schreyer, M., Baumgartner, M., Ruud, F., & Borth, D. (2022). Künstliche Intelligenz im Internal Audit als Beitrag zur effektiven Governance-Deep-Learning-basierte Detektion von Buchungsanomalien in der Revisionspraxis. Expert Focus, (01), 39-44.

[5] Ramamurthy, R., Pielka, M., Stenzel, R., Bauckhage, C., Sifa, R., Khameneh, T. D., Warning, U., Kliem, B., & Loitz, R. (2021, August). Alibert: Improved Automated List Inspection (ALI) with BERT. In Proceedings of the 21st ACM Symposium on Document Engineering (pp. 1-4).

[6] Konečný, J., McMahan, H. B., Yu, F. X., Richtárik, P., Suresh, A. T., & Bacon, D. (2016). Federated learning: Strategies for improving communication efficiency. arXiv preprint arXiv:1610.05492.

[7] Kairouz, P., McMahan, H. B., Avent, B., Bellet, A., Bennis, M., Bhagoji, A. N., … & Zhao, S. (2021). Advances and open problems in federated learning. Foundations and Trends in Machine Learning, 14(1–2), 1-210.

[8] Schreyer, M., Sattarov, T., & Borth, D. (2022, November). Federated and privacy-preserving learning of accounting data in financial statement audits. In Proceedings of the Third ACM International Conference on AI in Finance (pp. 105-113).

[9] Seidenstein, T., Marten, K. U., Donaldson, G., Föhr, T. L., Reichelt, V., & Jakoby, L. B. (2024). Innovation in audit and assurance: A global study of disruptive technologies. Journal of Emerging Technologies in Accounting, 21(1), 129-146.

[10] Hoitash, R., Kogan, A., & Vasarhelyi, M. A. (2006). Peer-based approach for analytical procedures. Auditing: A Journal of Practice & Theory, 25(2), 53-84.